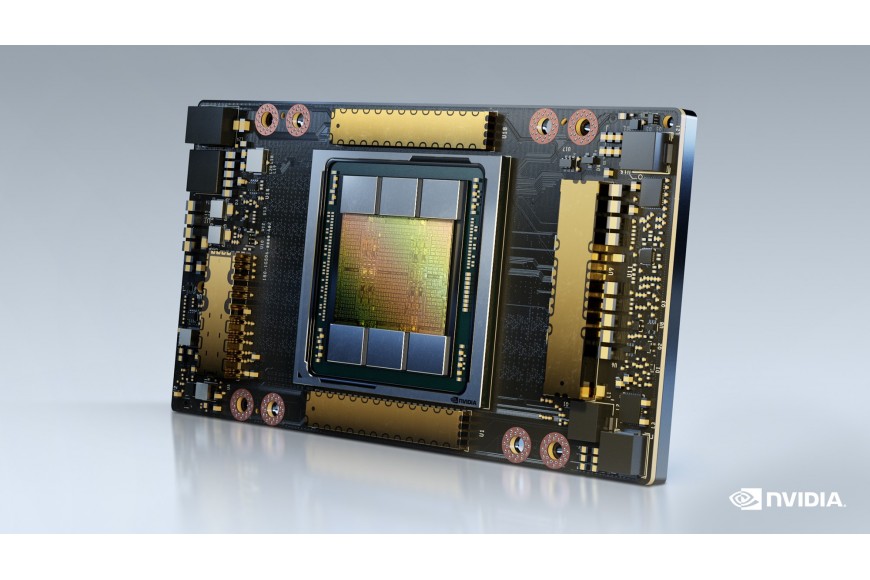

SC20 - NVIDIA a dévoilé aujourd'hui le GPU NVIDIA® A100 80 Go - la dernière innovation qui alimente la plate-forme de super informatique NVIDIA HGX ™ AI - avec deux fois la mémoire de son prédécesseur, offrant aux chercheurs et ingénieurs une vitesse et des performances sans précédent pour débloquer la prochaine vague d'IA et de percées scientifiques.

Le nouvel A100 doté de la technologie HBM2e double la mémoire à bande passante élevée du GPU A100 de 40 Go à 80 Go et fournit plus de 2 téraoctets par seconde de bande passante mémoire. Cela permet d’alimenter rapidement les données vers A100, le GPU de centre de données le plus rapide au monde, ce qui permet aux chercheurs d’accélérer leurs applications encore plus rapidement et de prendre en charge des modèles et des ensembles de données encore plus volumineux.

«Pour obtenir des résultats de pointe dans la recherche sur le HPC et l'IA, il faut construire les plus grands modèles, mais ceux-ci exigent plus de capacité de mémoire et de bande passante que jamais auparavant», a déclaré Bryan Catanzaro, vice-président de la recherche appliquée en deep learning chez NVIDIA. «Le GPU A100 de 80 Go fournit le double de la mémoire de son prédécesseur, qui a été introduit il y a à peine six mois, et brise la barrière des 2 To par seconde, permettant aux chercheurs de relever les plus importants défis scientifiques et de Big Data au monde.»

Le GPU NVIDIA A100 80 Go est disponible dans les systèmes NVIDIA DGX ™ A100 et NVIDIA DGX Station ™ A100, également annoncé aujourd'hui et devrait être livré ce trimestre.

Les principaux fournisseurs de systèmes Supermicro devraient commencer à proposer des systèmes construits à l'aide de plinthes intégrées HGX A100 dans des configurations à quatre ou huit GPU avec A100 80 Go au premier semestre 2021.

Alimenter les charges de travail gourmandes en données

S'appuyant sur les diverses capacités de l'A100 40 Go, la version 80 Go est idéale pour une large gamme d'applications avec d'énormes besoins en mémoire de données.

Pour la formation à l'IA, les modèles de système de recommandation tels que DLRM ont des tables massives représentant des milliards d'utilisateurs et des milliards de produits. L'A100 80 Go offre une accélération jusqu'à 3x, de sorte que les entreprises peuvent rapidement recycler ces modèles pour fournir des recommandations très précises.

Le GPU NVIDIA A100 80 Go est disponible dans les systèmes NVIDIA DGX ™ A100 et NVIDIA DGX Station ™ A100, également annoncé aujourd'hui et devrait être livré ce trimestre.

Les principaux fournisseurs de systèmes Supermicro devraient commencer à proposer des systèmes construits à l'aide de plinthes intégrées HGX A100 dans des configurations à quatre ou huit GPU avec A100 80 Go au premier semestre 2021.

Alimenter les charges de travail gourmandes en données

S'appuyant sur les diverses capacités de l'A100 40 Go, la version 80 Go est idéale pour une large gamme d'applications avec d'énormes besoins en mémoire de données.

Pour la formation à l'IA, les modèles de système de recommandation tels que DLRM ont des tables massives représentant des milliards d'utilisateurs et des milliards de produits. L'A100 80 Go offre une accélération jusqu'à 3x, de sorte que les entreprises peuvent rapidement recycler ces modèles pour fournir des recommandations très précises.

Pour les applications scientifiques, telles que les prévisions météorologiques et la chimie quantique, l'A100 80 Go peut fournir une accélération massive. Quantum Espresso, une simulation de matériaux, a réalisé des gains de débit de près de 2x avec un seul nœud de A100 80 Go.

«Une bande passante et une capacité mémoire rapides et importantes sont essentielles pour atteindre des performances élevées dans les applications de calcul intensif», a déclaré Satoshi Matsuoka, directeur du RIKEN Center for Computational Science. «Le NVIDIA A100 avec 80 Go de mémoire GPU HBM2e, fournissant les 2 To par seconde de bande passante les plus rapides au monde, contribuera à améliorer considérablement les performances des applications.»

Principales caractéristiques du A100 80 Go

L'A100 80 Go comprend les nombreuses fonctionnalités révolutionnaires de l'architecture NVIDIA Ampere:

Cœurs Tensor de troisième génération: fournissent jusqu'à 20 fois le débit AI de la génération Volta précédente avec un nouveau format TF32, ainsi que 2,5x FP64 pour HPC, 20x INT8 pour l'inférence AI et la prise en charge du format de données BF16.

Mémoire GPU HBM2e plus grande et plus rapide: double la capacité de la mémoire et est la première du secteur à offrir plus de 2 To par seconde de bande passante mémoire.

Technologie MIG: double la mémoire par instance isolée, fournissant jusqu'à sept MIG de 10 Go chacun.

Sparsity structurelle: offre jusqu'à 2 fois plus d'accélération en déduisant des modèles clairsemés.

NVLink® et NVSwitch ™ de troisième génération: fournissent deux fois la bande passante GPU-GPU de la technologie d'interconnexion de la génération précédente, accélérant les transferts de données vers le GPU pour les charges de travail gourmandes en données jusqu'à 600 gigaoctets par seconde.

Plateforme NVIDIA HGX AI Supercomputing

Le GPU A100 80 Go est un élément clé de la plate-forme de superinformatique NVIDIA HGX AI, qui réunit toute la puissance des GPU NVIDIA, NVIDIA NVLink, la mise en réseau NVIDIA InfiniBand et une pile logicielle NVIDIA AI et HPC entièrement optimisée pour fournir les meilleures performances d'application. Il permet aux chercheurs et aux scientifiques de combiner le HPC, l'analyse de données et les méthodes informatiques d'apprentissage en profondeur pour faire avancer le programme scientifique.